Sztuczna inteligencja na straży cyfrowych granic. Era AI w cyberbezpieczeństwie

Pewien duży bank co godzinę otrzymuje miliony logów systemowych. To dane o każdej próbie logowania, przelewie, aktywacji karty. Wśród tego cyfrowego szumu, gdzie tradycyjne, oparte na sygnaturach programy antywirusowe ledwo nadążają, ukryte są niemal niewidzialne próby włamania. Jedna z nich to subtelna anomalia: konto pracownika, które zwykle loguje się o 8:00 rano z biura w Warszawie, nagle o 3:00 w nocy próbuje uzyskać dostęp do poufnych baz danych z serwera zlokalizowanego w Wietnamie. Klasyczny system bezpieczeństwa mógłby to odnotować. Ale to sztuczna inteligencja (AI), analizując miliardy takich zdarzeń, natychmiast wychwyciła ten wzorzec jako unikalne i natychmiastowe zagrożenie, blokując dostęp w ułamku sekundy. W ten sposób AI zaoszczędziła bankowi milionowe straty, a klientom – utratę wrażliwych danych.

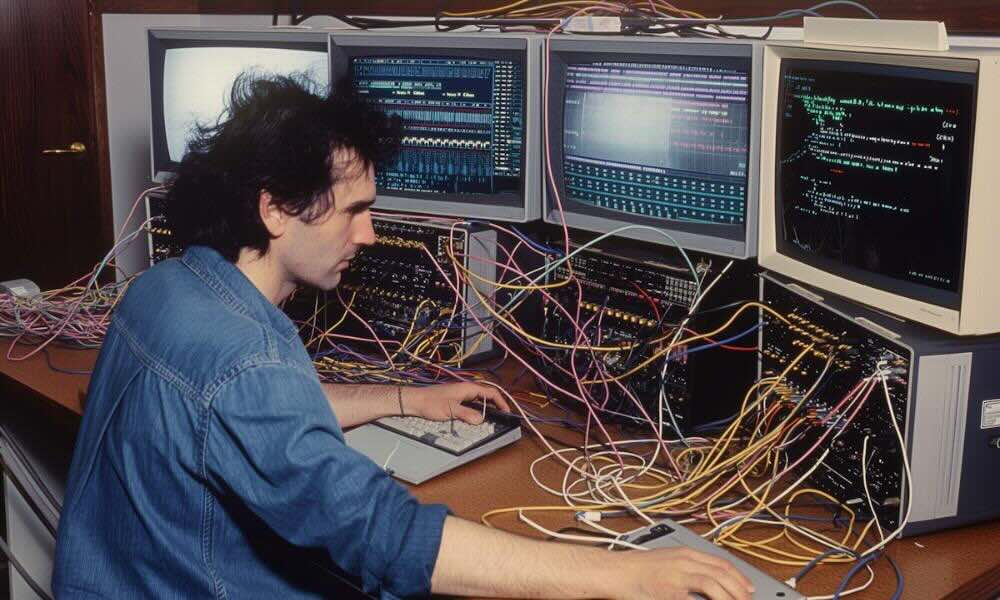

W dzisiejszym świecie, gdzie ataki hakerskie ewoluują z prędkością światła, a skala zagrożeń rośnie wykładniczo, poleganie wyłącznie na ludzkim zespole i ręcznych ustawieniach zabezpieczeń jest już niewystarczające. Cyberprzestępcy coraz częściej wykorzystują zautomatyzowane narzędzia oparte na AI, aby tworzyć wyrafinowane złośliwe oprogramowanie (malware) i przeprowadzać zmasowane ataki phishingowe. W odpowiedzi na ten wyścig zbrojeń, rozwój sztucznej inteligencji w cyberbezpieczeństwie staje się naszą najsilniejszą tarczą. AI nie tylko przyspiesza reakcję, ale przede wszystkim uczy się, przewiduje i automatyzuje obronę w sposób, którego człowiek nigdy nie byłby w stanie powtórzyć.

Dlaczego tradycyjne zabezpieczenia już nie wystarczają?

Tradycyjne systemy bezpieczeństwa (takie jak zapory ogniowe czy starsze antywirusy) działają w oparciu o sygnatury. Oznacza to, że potrafią zidentyfikować i zablokować zagrożenie, tylko jeśli już kiedyś je widziały i mają je w swojej bazie danych. To tak, jakby policja mogła złapać złodzieja tylko wtedy, gdy ten użyje dokładnie tego samego odcisku palca, co w poprzednim włamaniu.

Problem polega na tym, że hakerzy używają tzw. polimorficznego złośliwego oprogramowania, które potrafi zmieniać swój kod (sygnaturę) za każdym razem, gdy jest używane. W rezultacie każdego dnia powstają tysiące wariantów tego samego wirusa. Ludzki zespół bezpieczeństwa nie jest w stanie analizować i klasyfikować tak gigantycznej liczby nowych zagrożeń. To zadanie dla maszyny, a konkretnie dla machine learning (uczenia maszynowego), będącego sercem AI w bezpieczeństwie.

AI jako strażnik: wykrywanie anomalii i reagowanie

Kluczowa rola sztucznej inteligencji polega na analizie behawioralnej. Zamiast szukać znanego „odcisku palca” wirusa, AI uczy się, jak wygląda normalne, zdrowe zachowanie sieci, użytkowników i urządzeń. Kiedy pojawi się cokolwiek odbiegającego od tego wzorca – jest to natychmiast uznawane za anomalię i potencjalne zagrożenie.

Uczenie maszynowe i analiza predykcyjna

Systemy oparte na AI, wykorzystujące uczenie maszynowe (ML), robią dwie rewolucyjne rzeczy:

- Wykrywanie Zero-Day: AI potrafi zidentyfikować zupełnie nowe, nigdy wcześniej niewidziane ataki (tzw. zero-day) na podstawie ich zachowania, a nie tylko sygnatur. Jeśli plik zachowuje się jak wirus (np. próbuje modyfikować rejestr systemu, zaszyfrować pliki, komunikować się z podejrzanymi serwerami), AI go blokuje, zanim zdąży narobić szkód.

- Predykcja ryzyka: Modele AI analizują tysiące wskaźników ryzyka (np. wiek konta użytkownika, jego uprawnienia, ostatnia zmiana hasła, lokalizacja logowania) i potrafią przewidzieć, które zasoby są najbardziej narażone na atak. Dzięki temu zespoły bezpieczeństwa mogą proaktywnie wzmacniać obronę w najbardziej krytycznych punktach.

Ciekawostka: Jednym z najpopularniejszych zastosowań AI są systemy UEBA (User and Entity Behavior Analytics). Jeśli pracownik, który zwykle generuje 10 MB ruchu dziennie, nagle zaczyna pobierać 5 GB danych o północy, UEBA natychmiast go oznacza. To często znak, że jego konto zostało przejęte.

Automatyzacja obrony: sołar i soar

AI jest niezbędna do automatyzacji reakcji na zagrożenia. W przeciwnym razie analitycy bezpieczeństwa byliby zasypani milionami fałszywych alertów, co prowadziłoby do tzw. „zmęczenia alarmami” (alert fatigue).

W cyberbezpieczeństwie pojawiły się dwa kluczowe pojęcia, które wykorzystują AI/ML:

- SIEM (Security Information and Event Management): To podstawowy system, który zbiera i centralizuje logi ze wszystkich urządzeń w sieci.

- SOAR (Security Orchestration, Automation and Response): To narzędzie, które dostaje alert z SIEM i automatycznie podejmuje działania. Jeśli AI wykryje zagrożenie, SOAR może natychmiast:

- Izolować zainfekowane urządzenie od sieci.

- Zablokować podejrzane adresy IP na firewallu.

- Wymusić zmianę hasła podejrzanemu użytkownikowi.

- Wysłać zautomatyzowane powiadomienie do zespołu bezpieczeństwa.

Ciemna strona mocy: AI jako broń hakerów

Niestety, rozwój AI nie ogranicza się tylko do obrońców. Cyberprzestępcy również szybko adaptują te technologie, co prowadzi do nieustannego „wyścigu zbrojeń algorytmów”.

Deepfake i spersonalizowany phishing

Hakerzy wykorzystują AI do tworzenia niespotykanie wiarygodnych ataków socjotechnicznych:

- Deepfakes głosowe: Tak jak w historii pani Anny, AI potrafi klonować głos dowolnej osoby na podstawie kilkudziesięciu sekund nagrania. Może to być wykorzystane do oszustw na „wiceprezesa” dzwoniącego do działu finansowego z pilną prośbą o przelew.

- AI-Phishing: Modele językowe (jak GPT-4) pozwalają hakerom na generowanie idealnie spersonalizowanych, pozbawionych błędów gramatycznych i stylistycznych e-maili phishingowych, które są niemal nie do odróżnienia od autentycznych wiadomości biznesowych.

- Złośliwe oprogramowanie (Malware) 2.0: Sztuczna inteligencja jest wykorzystywana do testowania luk w zabezpieczeniach systemów ofiary i automatycznego generowania najlepiej dopasowanego, polimorficznego złośliwego oprogramowania, które omija tradycyjne antywirusy.

Ta nowa kategoria zagrożeń wymusza na firmach i użytkownikach końcowych podniesienie czujności i stosowanie równie zaawansowanych narzędzi obronnych.

Wyzwania i ograniczenia wykorzystania AI

Choć rola sztucznej inteligencji w bezpieczeństwie IT jest kluczowa, niesie ze sobą również pewne wady i ograniczenia, o których należy pamiętać.

Tabela: korzyści vs. ograniczenia ai w cyberbezpieczeństwie

| Korzyści (Za) | Ograniczenia i Wyzwania (Przeciw) |

|---|---|

| Automatyczne wykrywanie nowych (Zero-Day) zagrożeń. | Fałszywe Pozytywy (False Positives): AI może błędnie oznaczać normalne zachowanie jako zagrożenie, blokując kluczowe procesy. |

| Skalowalna, 24/7/365 ochrona – AI się nie męczy. | Koszty i Złożoność: Wdrożenie i utrzymanie zaawansowanych systemów AI/ML wymaga dużych inwestycji w sprzęt i specjalistów. |

| Błyskawiczna reakcja i automatyczne blokowanie ataków (SOAR). | Ataki na Modele AI: Hakerzy uczą się, jak „oszukać” algorytmy AI (tzw. ataki Adwersarialne). |

| Analiza miliardów punktów danych w czasie rzeczywistym (UEBA, SIEM). | Brak Ludzkiego Osądu: W sytuacjach bezprecedensowych, AI wciąż potrzebuje człowieka do podjęcia ostatecznej, strategicznej decyzji. |

Problem interpretowalności (explainable ai)

Kolejnym poważnym wyzwaniem jest tzw. problem czarnej skrzynki. Zaawansowane modele głębokiego uczenia (deep learning) są tak skomplikowane, że nawet ich twórcy nie zawsze potrafią precyzyjnie określić, dlaczego system podjął daną decyzję (np. dlaczego zablokował konkretny plik, uznając go za złośliwy). W krytycznych sytuacjach (np. podczas audytu prawnego) musimy wiedzieć, dlaczego AI zadziałała. Stąd rośnie znaczenie koncepcji Explainable AI (XAI) – budowania modeli, które potrafią wyjaśnić swoje decyzje.

Konkretne rozwiązania: produkty i narzędzia wykorzystujące ai

Wiele firm, od globalnych gigantów po start-upy, oferuje już rozwiązania oparte na AI/ML. Dzięki temu technologie te stają się dostępne także dla mniejszych firm.

- Cortex XDR (Palo Alto Networks): Platforma łączy dane z punktów końcowych, sieci i chmury, wykorzystując ML do automatycznego wykrywania i powstrzymywania zaawansowanych ataków.

- CrowdStrike Falcon: Lider w ochronie punktów końcowych (EDR), którego modele ML uczą się behawioru plików, by neutralizować ransomware i inne zagrożenia w czasie rzeczywistym.

- IBM QRadar Advisor with Watson: Wykorzystuje zdolności analityczne sztucznej inteligencji Watson do przetwarzania języka naturalnego, by korelować alerty bezpieczeństwa i przyspieszać dochodzenia.

- Darktrace: Wykorzystuje samouczące się AI, wzorując się na ludzkim układzie odpornościowym, do ciągłego budowania „poczucia siebie” (normalności) w sieci i natychmiastowej neutralizacji nietypowych zachowań.

Twoja rola w erze ai: jak się zabezpieczyć?

AI przejmuje walkę na poziomie maszyn, ale to Ty jesteś ostatnią linią obrony przed socjotechniką. Pamiętaj, że nawet najdoskonalsza AI nie ochroni Cię przed oszustwem, jeśli sam podasz hasło.

Praktyczne kroki dla każdego:

- Zweryfikuj tożsamość dzwoniącego: Jeśli ktoś dzwoni z prośbą o pilny przelew lub dane, rozłącz się. Zadzwoń do tej osoby na znany Ci, autoryzowany numer telefonu (nie oddzwaniaj na numer, z którego dzwonił oszust). Pamiętaj o oszustwach typu deepfake głosowy.

- Włącz uwierzytelnianie wieloskładnikowe (MFA): To absolutna podstawa. Nawet jeśli AI-haker zdobędzie Twoje hasło, nie wejdzie na konto.

- Używaj menedżera haseł: Ochrona przed atakami słownikowymi i wyciekami haseł.

- Pytaj o AI-ochronę: Jeśli kupujesz antywirusa lub usługę VPN, sprawdź, czy wykorzystują uczenie maszynowe do analizy behawioralnej, a nie tylko sygnatur.

Najczęściej zadawane pytania (faq)

Czy sztuczna inteligencja zastąpi analityków cyberbezpieczeństwa?

Nie. AI nie zastąpi ludzi, ale zmieni ich pracę. AI przejmie nudne, powtarzalne zadania (np. filtrowanie milionów fałszywych alertów i automatyczne reagowanie na proste zagrożenia). Analitycy będą mogli skupić się na bardziej złożonych, strategicznych zadaniach, analizie incydentów na najwyższym poziomie i podejmowaniu decyzji, do których wciąż niezbędny jest ludzki osąd.

Co to są ataki adwersarialne (adversarial attacks)?

To ataki hakerów, którzy celowo wprowadzają subtelne, niezauważalne dla człowieka zmiany w danych, aby „oszukać” model sztucznej inteligencji. Na przykład, nieznacznie zmieniając kilka pikseli na obrazie, mogą sprawić, że AI pomyli znak stop z przejściem dla pieszych. W cyberbezpieczeństwie oznacza to np. dodawanie „szumu” do złośliwego oprogramowania w taki sposób, aby AI uznała je za bezpieczny plik, podczas gdy tradycyjny antywirus by go zablokował.

Czy ai chroni przed ransomware?

Tak, i to bardzo skutecznie. Starsze systemy czekały, aż ransomware zacznie szyfrować pliki. Systemy oparte na AI monitorują zachowanie. Jeśli plik o dziwnej nazwie nagle zaczyna masowo odczytywać, modyfikować i zapisywać inne pliki z szybkością niezgodną z normalnym zachowaniem systemu – AI natychmiast izoluje i blokuje ten proces, zatrzymując szyfrowanie na samym początku. To jest właśnie siła behawioralnej analizy AI.

Przyszłość cyberbezpieczeństwa jest ściśle związana ze sztuczną inteligencją. AI to nie tylko trend technologiczny, ale nowa konieczność w utrzymaniu cyfrowej równowagi. Musimy być czujni, ponieważ nasz wróg – cyberprzestępca – również ma dostęp do tych samych potężnych narzędzi.

Kluczem jest zrozumienie, że skuteczna obrona polega na hybrydzie: szybkich, skalowalnych i przewidujących algorytmach AI oraz zdrowym rozsądku i strategicznym myśleniu ludzkich zespołów. Zabezpiecz swoją firmę i swoją cyfrową tożsamość, wdrażając te nowoczesne praktyki już dziś.